ホーム > 畜産 > 畜産の情報 > 乳牛のリアルタイム映像モニタリング実現のための斑紋からの高速・高精度個体識別技術の開発

国立研究開発法人農業・食品産業技術総合研究機構 北海道農業研究センター 多田慎吾

【要約】

映像上での個体同士の重なりが頻発する斜め撮影の牛舎内映像を対象としても、斑紋からの高速・高精度個体識別を可能とすることを目的として、斜め撮影の牛舎内画像から牛体の境界範囲を高精度に検出できるAI(人工知能)モデルを作成した。これを利用することで映像中の個体ごとに背景や他個体との重なりを除いた体範囲のみを抽出することが可能となり、ホルスタイン種乳牛の斑紋特徴による個体識別の精度を向上させられることを示した。また、これらの技術をコンピュータプログラムとして実装し、映像のフレームレート(コマ数/秒)が1〜2程度の範囲であれば、リアルタイムでの牛体境界検出および個体識別が実行可能な映像解析プログラムを実現できることを示した。

1 研究の背景と目的

酪農経営において乳牛1頭当たりの生涯生産性を高めるためには、アニマルウェルフェアのレベルを維持しつつ、採食や休息といった個体維持行動が正常に保たれるよう飼養管理することが求められる。これには日常的に乳牛の行動を把握することが重要である。飼養頭数が中規模程度までの酪農家やつなぎ飼い牛舎で飼養する場合は、各個体に目が行き届きやすく、異常が生じた場合でも早期対応をとることができる場合も多い。しかしながら、近年1戸当たり飼養頭数は大きく増え、つなぎ飼い方式からフリーストールのような放し飼い方式への転換が進んでいる。牛群の大規模化に伴い乳牛の行動把握および個体ごとの精密な飼養管理がより困難な状況となっており、異常発見の遅れによる症状の重篤化やその対処にともなう労力の増加を招くケースも多い。

このような課題を解決する目的で、近年、放し飼いの牛を対象とした、映像解析による行動モニタリング技術が開発されつつある(例 コンピューター総合研究所,2017;東京理科大ら,2019;農研機構北農研, 2020,2021;Tassinariら,2021)。同様の目的のものに、牛に万歩計や加速度計のようなウェアラブルセンサを装着し行動データを収集する手法もあるが、映像解析に基づく手法はカメラさえ設置すれば、各個体へウェアラブルセンサを取り付ける費用や労力が生じないため、低コストかつ省力的なシステムとして実用化が期待されている。

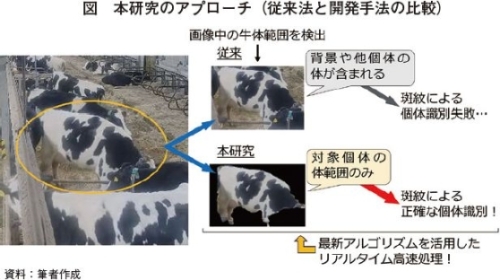

このような映像システムにおいて重要となるのが、いかにして個体識別を可能とするか、という点である。ウェアラブルセンサシステムとの差別化のためにも装着型マーカーを利用せずに個体識別できることが望ましい。ホルスタイン種乳牛(以下「乳牛」という)の個体識別手法としては、体表の斑紋特徴を利用する機械学習による方法が検討され、ある程度の有効性が示されている(例 Zinら,2018;田口ら,2019;Tassinariら,2021)。しかし、映像システムにおいては画面上で牛体範囲を検出し、同範囲に含まれる斑紋情報に基づき個体識別をすることとなるが、この範囲に密集した他個体の体部分や対象個体の体範囲外の背景が含まれると、識別精度が極端に低下してしまう問題がある。

そこで本研究では、このボトルネックを解消するアイデアとして、最新のリアルタイム画像セグメンテーション(画像処理)手法の適用を試みた。ここで用いる画像インスタンスセグメンテーションとは、深層学習により検出する対象物の境界の推定を可能とする技術である(写真1)。同手法により、映像画面中の特定個体の範囲のみを切り出すことができるため、その個体の斑紋特徴をより正確に抽出することが可能となり、個体識別の精度が向上すると見込まれる(図)。従来、同手法は処理に時間を要したが、近年の人工知能技術の進歩、改良に伴いリアルタイム解析用途に適した方法も開発されている(Bolyaら,2019,2020)。本研究ではこれを乳牛画像へ応用し、(1)映像中の牛体範囲を正確に検出できる画像セグメンテーションモデルを作成するとともに、(2)同モデルから検出される牛体範囲の斑紋特徴を利用した高速・高精度個体識別技術を開発することを目的とした。

このような課題を解決する目的で、近年、放し飼いの牛を対象とした、映像解析による行動モニタリング技術が開発されつつある(例 コンピューター総合研究所,2017;東京理科大ら,2019;農研機構北農研, 2020,2021;Tassinariら,2021)。同様の目的のものに、牛に万歩計や加速度計のようなウェアラブルセンサを装着し行動データを収集する手法もあるが、映像解析に基づく手法はカメラさえ設置すれば、各個体へウェアラブルセンサを取り付ける費用や労力が生じないため、低コストかつ省力的なシステムとして実用化が期待されている。

このような映像システムにおいて重要となるのが、いかにして個体識別を可能とするか、という点である。ウェアラブルセンサシステムとの差別化のためにも装着型マーカーを利用せずに個体識別できることが望ましい。ホルスタイン種乳牛(以下「乳牛」という)の個体識別手法としては、体表の斑紋特徴を利用する機械学習による方法が検討され、ある程度の有効性が示されている(例 Zinら,2018;田口ら,2019;Tassinariら,2021)。しかし、映像システムにおいては画面上で牛体範囲を検出し、同範囲に含まれる斑紋情報に基づき個体識別をすることとなるが、この範囲に密集した他個体の体部分や対象個体の体範囲外の背景が含まれると、識別精度が極端に低下してしまう問題がある。

そこで本研究では、このボトルネックを解消するアイデアとして、最新のリアルタイム画像セグメンテーション(画像処理)手法の適用を試みた。ここで用いる画像インスタンスセグメンテーションとは、深層学習により検出する対象物の境界の推定を可能とする技術である(写真1)。同手法により、映像画面中の特定個体の範囲のみを切り出すことができるため、その個体の斑紋特徴をより正確に抽出することが可能となり、個体識別の精度が向上すると見込まれる(図)。従来、同手法は処理に時間を要したが、近年の人工知能技術の進歩、改良に伴いリアルタイム解析用途に適した方法も開発されている(Bolyaら,2019,2020)。本研究ではこれを乳牛画像へ応用し、(1)映像中の牛体範囲を正確に検出できる画像セグメンテーションモデルを作成するとともに、(2)同モデルから検出される牛体範囲の斑紋特徴を利用した高速・高精度個体識別技術を開発することを目的とした。

2 材料および方法

(1)牛舎内乳牛映像に適用可能な画像セグメンテーションモデルの作成

ア 映像データ収集および機械学習用データセットの作成

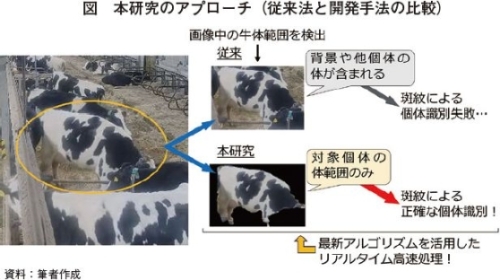

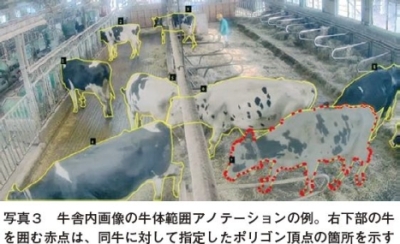

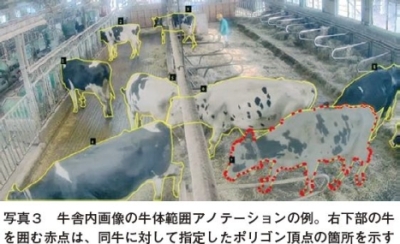

農業・食品産業技術総合研究機構北海道農業研究センター(以下「センター」という)の放し飼い方式の搾乳牛牛舎に設置した4台のネットワークカメラ(Panasonic社、WV-S2570LNJ 2台、Panasonic社、BB-SW374 2台)を用いて、牛舎内を連続撮影し、得られた延べ約28カ月分の動画データを用いた(写真2)。このようにさまざまな撮影位置および角度からの映像を利用することで、牛の映り方によらない汎用性の高い牛体検出モデルが作成できると期待される。この映像データを基に画面の全体あるいは一部を画像として切り出し、合計3678枚の画像データを得た。この大量の牛舎内画像について、牛体範囲をポリゴン(多角形)頂点で囲うアノテーション作業を実施した(写真3)。アノテーション作業にはVGG Image Annotator(https://www.robots.ox.ac.uk/~vgg/software/via/)を用いた。これらの画像のうち、3126枚を画像セグメンテーションモデルの学習用データとし、残りの552枚は精度検証のためのテストデータとした。

イ 画像セグメンテーションモデルの作成

本調査ではBolyaら(2020)が報告しているYOLACT++と呼ばれる手法を応用して牛舎内の乳牛画像を対象に適用した。同手法は、リアルタイムでの画像インスタンスセグメンテーションを可能とした機械学習モデルであり、計算速度が非常に速く、精度も高い方法として知られている。本調査では、Bolyaら(2019,2020)が公開しているPython言語のプログラムコード(https://github.com/dbolya/yolact)を自身の開発環境(Windows10、Anaconda(https://www.anaconda.com/)を利用)にて実行し、前述のアノテーション済み牛舎画像データセットを同モデルに学習させることで、牛体の境界を検出できるオリジナルの画像セグメンテーションモデルを作成した。

ウ 作成した画像セグメンテーションモデルの精度評価

前述の精度検証用テストデータ552枚に対して、作成した画像セグメンテーションモデルによる牛体検出を試行し、精度評価を行った。評価指標としてIntersection Over Union(以下「IOU」という)の閾値を0.5以上、もしくは0.75以上とした際の、Precision(適合率)とRecall(再現率)を用いた。IOUとは、モデルにより検出された領域と正解の領域との重なっている領域の比率を示し、1.0で完全一致、0.0で重なりなしを示す。本研究ではこのIOUの閾値として、一般的な物体検出の評価で適用される0.5と、より厳しい基準であり、ほぼ正確に牛体範囲を検出できたとみなせる0.75の二つを用いることとした。Precisionはいかに正確に範囲を検出できるかの指標であり、すべての検出範囲の個数の内、IOUの閾値以上での予測に成功した個数の割合(精度)を表すこととなる。また、Recallはいかに漏れなく検出できるかの指標であり、検出されるべき範囲の個数の内、IOUの閾値以上で検出できた個数の割合(感度)を表すこととなる。

(2)画像セグメンテーションモデルから取得した斑紋画像に基づく乳牛個体識別技術の開発、実装および性能評価

ア 個体識別に供する画像の切り出し

解析対象には(1)と同様に、センターの放し飼い方式の搾乳牛牛舎にて収集した映像データを用いた。同映像データを基に(1)で作成した画像セグメンテーションモデルを利用して映像中の牛体範囲を検出し、同範囲を画像として切り出した。なお、この際に牛体範囲を矩形(くけい)としてそのまま切り出したものを「従来法」によるもの、同矩形範囲内の牛体範囲以外をマスクして切り出したものを「開発手法」によるものとして、二つのパターンの画像を生成した(図)。以上により、合計59頭の乳牛個体から計2万9526枚の画像を得た(「従来法」および「開発手法」おのおので)。これを個体ごとに分類して、個体識別用畳み込みニューラルネットワークモデルの学習用データ(2万2658枚)および精度検証のためのテストデータ(6868枚)とした。

イ 個体識別精度の比較

個体識別を行うための判別器としてResNet50モデル(Heら,2015)を用いた。同モデルは画像の特徴量抽出に優れた性能を持つことが知られる畳み込みニューラルネットワークモデルである。これを上述の乳牛個体別切り出し画像について学習させることで、画像を基に個体IDを判別するモデルを作成した。判別モデルは「従来法」および「開発手法」の画像、それぞれの場合について作成した。作成した判別モデルを、学習に用いなかったテストデータを対象に適用し、個体識別の正解率を算出した。以上のResNet50モデルの実行はPythonの計算ライブラリPytorch(http://pytorch.org/)を用いて行った。

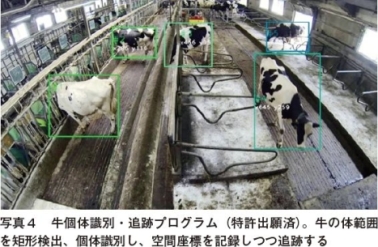

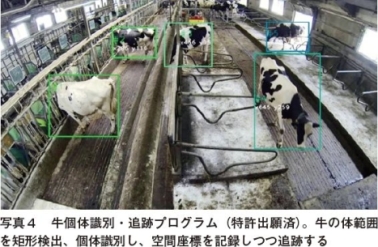

ウ 牛舎内映像からのリアルタイム乳牛検出・個体識別プログラムの作成

調査者は牛舎内映像からの牛個体識別・追跡プログラム(特許出願済; 農研機構北農研, 2020,2021;写真4)の開発に取り組んできた。これは画像解析技術と複数の機械学習手法を組み合わせたもので、牛体範囲を矩形検出した後、同範囲に含まれる斑紋特徴から畳み込みニューラルネットワーク判別モデルにより個体識別し、追跡する構成となっている。本研究では、同プログラムの牛体範囲矩形検出ステップを、(1)で開発した画像セグメンテーションモデルによる検出に置き換え、背景や他個体の体部位を除いた画像を個体識別に用いた、新たなプログラムを作成した。同プログラムを、実際の牛舎映像データを対象に適用し、解析処理に係る速度を検証した。

ア 映像データ収集および機械学習用データセットの作成

農業・食品産業技術総合研究機構北海道農業研究センター(以下「センター」という)の放し飼い方式の搾乳牛牛舎に設置した4台のネットワークカメラ(Panasonic社、WV-S2570LNJ 2台、Panasonic社、BB-SW374 2台)を用いて、牛舎内を連続撮影し、得られた延べ約28カ月分の動画データを用いた(写真2)。このようにさまざまな撮影位置および角度からの映像を利用することで、牛の映り方によらない汎用性の高い牛体検出モデルが作成できると期待される。この映像データを基に画面の全体あるいは一部を画像として切り出し、合計3678枚の画像データを得た。この大量の牛舎内画像について、牛体範囲をポリゴン(多角形)頂点で囲うアノテーション作業を実施した(写真3)。アノテーション作業にはVGG Image Annotator(https://www.robots.ox.ac.uk/~vgg/software/via/)を用いた。これらの画像のうち、3126枚を画像セグメンテーションモデルの学習用データとし、残りの552枚は精度検証のためのテストデータとした。

イ 画像セグメンテーションモデルの作成

本調査ではBolyaら(2020)が報告しているYOLACT++と呼ばれる手法を応用して牛舎内の乳牛画像を対象に適用した。同手法は、リアルタイムでの画像インスタンスセグメンテーションを可能とした機械学習モデルであり、計算速度が非常に速く、精度も高い方法として知られている。本調査では、Bolyaら(2019,2020)が公開しているPython言語のプログラムコード(https://github.com/dbolya/yolact)を自身の開発環境(Windows10、Anaconda(https://www.anaconda.com/)を利用)にて実行し、前述のアノテーション済み牛舎画像データセットを同モデルに学習させることで、牛体の境界を検出できるオリジナルの画像セグメンテーションモデルを作成した。

ウ 作成した画像セグメンテーションモデルの精度評価

前述の精度検証用テストデータ552枚に対して、作成した画像セグメンテーションモデルによる牛体検出を試行し、精度評価を行った。評価指標としてIntersection Over Union(以下「IOU」という)の閾値を0.5以上、もしくは0.75以上とした際の、Precision(適合率)とRecall(再現率)を用いた。IOUとは、モデルにより検出された領域と正解の領域との重なっている領域の比率を示し、1.0で完全一致、0.0で重なりなしを示す。本研究ではこのIOUの閾値として、一般的な物体検出の評価で適用される0.5と、より厳しい基準であり、ほぼ正確に牛体範囲を検出できたとみなせる0.75の二つを用いることとした。Precisionはいかに正確に範囲を検出できるかの指標であり、すべての検出範囲の個数の内、IOUの閾値以上での予測に成功した個数の割合(精度)を表すこととなる。また、Recallはいかに漏れなく検出できるかの指標であり、検出されるべき範囲の個数の内、IOUの閾値以上で検出できた個数の割合(感度)を表すこととなる。

(2)画像セグメンテーションモデルから取得した斑紋画像に基づく乳牛個体識別技術の開発、実装および性能評価

ア 個体識別に供する画像の切り出し

解析対象には(1)と同様に、センターの放し飼い方式の搾乳牛牛舎にて収集した映像データを用いた。同映像データを基に(1)で作成した画像セグメンテーションモデルを利用して映像中の牛体範囲を検出し、同範囲を画像として切り出した。なお、この際に牛体範囲を矩形(くけい)としてそのまま切り出したものを「従来法」によるもの、同矩形範囲内の牛体範囲以外をマスクして切り出したものを「開発手法」によるものとして、二つのパターンの画像を生成した(図)。以上により、合計59頭の乳牛個体から計2万9526枚の画像を得た(「従来法」および「開発手法」おのおので)。これを個体ごとに分類して、個体識別用畳み込みニューラルネットワークモデルの学習用データ(2万2658枚)および精度検証のためのテストデータ(6868枚)とした。

イ 個体識別精度の比較

個体識別を行うための判別器としてResNet50モデル(Heら,2015)を用いた。同モデルは画像の特徴量抽出に優れた性能を持つことが知られる畳み込みニューラルネットワークモデルである。これを上述の乳牛個体別切り出し画像について学習させることで、画像を基に個体IDを判別するモデルを作成した。判別モデルは「従来法」および「開発手法」の画像、それぞれの場合について作成した。作成した判別モデルを、学習に用いなかったテストデータを対象に適用し、個体識別の正解率を算出した。以上のResNet50モデルの実行はPythonの計算ライブラリPytorch(http://pytorch.org/)を用いて行った。

ウ 牛舎内映像からのリアルタイム乳牛検出・個体識別プログラムの作成

調査者は牛舎内映像からの牛個体識別・追跡プログラム(特許出願済; 農研機構北農研, 2020,2021;写真4)の開発に取り組んできた。これは画像解析技術と複数の機械学習手法を組み合わせたもので、牛体範囲を矩形検出した後、同範囲に含まれる斑紋特徴から畳み込みニューラルネットワーク判別モデルにより個体識別し、追跡する構成となっている。本研究では、同プログラムの牛体範囲矩形検出ステップを、(1)で開発した画像セグメンテーションモデルによる検出に置き換え、背景や他個体の体部位を除いた画像を個体識別に用いた、新たなプログラムを作成した。同プログラムを、実際の牛舎映像データを対象に適用し、解析処理に係る速度を検証した。

3 結果および考察

(1)牛舎内乳牛映像に適用可能な画像セグメンテーションモデルの作成

本調査にて作成した牛体境界範囲検出用セグメンテーションモデルの精度指標は、IOUの閾値を0.5以上とした際は、Precisionが91.8%、Recallが71.5%、IOUの閾値を0.75以上とした際は、Precisionが78.7%、Recallが61.3%であった。Precisionの値はどれだけ正確に牛体範囲を検出できたかを示す。すなわち、検出した範囲の個数の内、91.8%と非常に高い割合でIOU 0.5以上にて牛体範囲を検出でき、78.7%については0.75以上の高いIOUで牛体範囲を検出できたことを意味する。また、Recallの値は検出漏れの少なさを示し、IOUの閾値が0.5の場合においても、検出すべき範囲の個数の内、3割程度は検出できなかったことを意味する。このように本調査で作成した画像セグメンテーションモデルは、ある程度の検出漏れはあるものの、検出した対象に関しては正確に牛体範囲の検出が可能であったといえる。従って、本調査の個体識別精度向上の目的のために対象個体の体範囲のみを抽出する用途には充分適用可能と考えられた。

(2)画像セグメンテーションモデルから取得の斑紋画像に基づく乳牛個体識別技術の開発、実装および性能評価

本調査では、同じ乳牛個体画像を対象に、背景や他個体を含めたまま個体識別に供する場合(従来法)と、(1)の画像セグメンテーションモデルを用いて牛体範囲以外をマスク処理し、これを個体識別に用いる場合(開発手法)とで、識別の正解率を比較した。その結果、個体識別の正解率は従来法では65.4%、開発手法では70.1%となり、4.7ポイント精度を向上させることができた。これは本調査の想定の通り、対象個体の識別に際して、他個体の映り込みや背景といったノイズが除かれ、個体自体の斑紋特徴をより正確に抽出できたためと考えられた。一方で、個体識別の正解率は開発手法においても70%程度にとどまった。本調査の撮影条件では牛体がさまざまな向きで撮影されるため、同一個体であっても映り方や斑紋特徴にばらつきがあったことが、誤識別の要因となった可能性がある。

本調査ではさらに同技術をコンピュータプログラムとして実装し、映像から個体ごとの乳牛の境界範囲を検出するとともに、同範囲の個体を識別するプログラムを作成した(写真5)。画像セグメンテーションモデルを実行しつつ、畳み込みニューラルネットワークモデルによる個体識別を行う計算負荷の高い処理を行うこととなるが、中程度の性能のAI推論用GPU(本調査ではNVIDIA社、GeForce GTX 1650 Ti)を利用するパーソナルコンピュータであれば、映像1フレーム当たりの解析処理時間が0.4〜0.7秒程度となることが確認できた。すなわち、映像のフレームレート(コマ数/秒)が1〜2程度であれば、リアルタイムでの乳牛検出・個体識別が実現できると考えられた。一方で、実際の適用に当たってはこのような短い時間間隔でフレームごとに解析を実行する必要はないと思われ、数秒に1度の解析といったより計算負荷の少ない条件での運用も想定される。

本調査にて作成した牛体境界範囲検出用セグメンテーションモデルの精度指標は、IOUの閾値を0.5以上とした際は、Precisionが91.8%、Recallが71.5%、IOUの閾値を0.75以上とした際は、Precisionが78.7%、Recallが61.3%であった。Precisionの値はどれだけ正確に牛体範囲を検出できたかを示す。すなわち、検出した範囲の個数の内、91.8%と非常に高い割合でIOU 0.5以上にて牛体範囲を検出でき、78.7%については0.75以上の高いIOUで牛体範囲を検出できたことを意味する。また、Recallの値は検出漏れの少なさを示し、IOUの閾値が0.5の場合においても、検出すべき範囲の個数の内、3割程度は検出できなかったことを意味する。このように本調査で作成した画像セグメンテーションモデルは、ある程度の検出漏れはあるものの、検出した対象に関しては正確に牛体範囲の検出が可能であったといえる。従って、本調査の個体識別精度向上の目的のために対象個体の体範囲のみを抽出する用途には充分適用可能と考えられた。

(2)画像セグメンテーションモデルから取得の斑紋画像に基づく乳牛個体識別技術の開発、実装および性能評価

本調査では、同じ乳牛個体画像を対象に、背景や他個体を含めたまま個体識別に供する場合(従来法)と、(1)の画像セグメンテーションモデルを用いて牛体範囲以外をマスク処理し、これを個体識別に用いる場合(開発手法)とで、識別の正解率を比較した。その結果、個体識別の正解率は従来法では65.4%、開発手法では70.1%となり、4.7ポイント精度を向上させることができた。これは本調査の想定の通り、対象個体の識別に際して、他個体の映り込みや背景といったノイズが除かれ、個体自体の斑紋特徴をより正確に抽出できたためと考えられた。一方で、個体識別の正解率は開発手法においても70%程度にとどまった。本調査の撮影条件では牛体がさまざまな向きで撮影されるため、同一個体であっても映り方や斑紋特徴にばらつきがあったことが、誤識別の要因となった可能性がある。

本調査ではさらに同技術をコンピュータプログラムとして実装し、映像から個体ごとの乳牛の境界範囲を検出するとともに、同範囲の個体を識別するプログラムを作成した(写真5)。画像セグメンテーションモデルを実行しつつ、畳み込みニューラルネットワークモデルによる個体識別を行う計算負荷の高い処理を行うこととなるが、中程度の性能のAI推論用GPU(本調査ではNVIDIA社、GeForce GTX 1650 Ti)を利用するパーソナルコンピュータであれば、映像1フレーム当たりの解析処理時間が0.4〜0.7秒程度となることが確認できた。すなわち、映像のフレームレート(コマ数/秒)が1〜2程度であれば、リアルタイムでの乳牛検出・個体識別が実現できると考えられた。一方で、実際の適用に当たってはこのような短い時間間隔でフレームごとに解析を実行する必要はないと思われ、数秒に1度の解析といったより計算負荷の少ない条件での運用も想定される。

4 まとめと今後の展望

本調査での開発技術により、映像上での個体同士の重なりが頻発する斜め撮影の牛舎内映像を対象としても、正確に乳牛の牛体範囲を検出しつつ、ある程度高精度で個体識別するところまでを、リアルタイムで実現できることが示された。同技術は、単純に個体の位置を発見する用途にも利用可能である他、映像に基づく行動モニタリングシステムの実用化に向けても大いに応用が期待される。一方で、本調査にて達成できた斑紋特徴に基づく個体識別の正解率は70%程度となり、個体ごとの正確な行動モニタリングへの応用に向けてはさらなる精度向上が求められる。また、本調査では一つの牛舎のみから得られた映像を供試したため、開発技術の汎化性能を高める取り組みも必要と考えられる。今後は複数の実証地にて映像データを取得、技術検証するとともに、より高度な特徴量抽出モデルの適用や個体識別の際の牛の体の向き補正といった方策を組み合わせ、汎用性および精度の向上に努める。これにより低コストかつ省力的な酪農管理者支援ツールを実現・提供することを目指したい。

参考文献

Bolya et al., 2019. YOLACT: Real-time Instance Segmentation. ICCV.

Bolya et al., 2020. YOLACT++: Better Real-time Instance Segmentation. IEEE Transactions on Pattern Analysis and Machine Intelligence.

コンピューター総合研究所. 2017. 牛の行動監視システム MOH-CAL. https://moh-cal.com/ [ホームページ].

He et al., 2015. Deep residual learning for image recognition. arXiv:1512.03385.

農研機構. 2020. 学習用データ生成装置、学習装置、行動分析装置、プログラム、及び記録媒体. 特願2020-114316. [特許出願]

農研機構. 2021. 学習用データ生成装置、学習装置、行動分析装置、行動型分析装置、プログラム、及び記録媒体. 特願2021-110070. [特許出願].

田口ら. 2019. ドローンによる牧場空撮画像における乳牛の個体識別. SSII.

Tassinari et al., 2021. A computer vision approach based on deep learning for the detection of dairy cows in free stall barn. Computers and Electronics in Agriculture.

東京理科大学. 2019. 北海道初!5GとAI技術による乳用牛の映像を用いた個体管理システムの実証実験を開始. [プレリリース].

Zin et al., 2018. Image technology based cowientification system using deep learning. IMECS.

参考文献

Bolya et al., 2019. YOLACT: Real-time Instance Segmentation. ICCV.

Bolya et al., 2020. YOLACT++: Better Real-time Instance Segmentation. IEEE Transactions on Pattern Analysis and Machine Intelligence.

コンピューター総合研究所. 2017. 牛の行動監視システム MOH-CAL. https://moh-cal.com/ [ホームページ].

He et al., 2015. Deep residual learning for image recognition. arXiv:1512.03385.

農研機構. 2020. 学習用データ生成装置、学習装置、行動分析装置、プログラム、及び記録媒体. 特願2020-114316. [特許出願]

農研機構. 2021. 学習用データ生成装置、学習装置、行動分析装置、行動型分析装置、プログラム、及び記録媒体. 特願2021-110070. [特許出願].

田口ら. 2019. ドローンによる牧場空撮画像における乳牛の個体識別. SSII.

Tassinari et al., 2021. A computer vision approach based on deep learning for the detection of dairy cows in free stall barn. Computers and Electronics in Agriculture.

東京理科大学. 2019. 北海道初!5GとAI技術による乳用牛の映像を用いた個体管理システムの実証実験を開始. [プレリリース].

Zin et al., 2018. Image technology based cowientification system using deep learning. IMECS.